[투자공부] HBM에 대해서 알아보자

개요

최근 언론 및 반도체 주식과 관련하여 이야기가 많이 나오고 있는 HBM에 대하여 어떠한 이유로 구설수에 오르고 관련주식들이 급등하고 있는지 공부하는데 목적을 둔다.

본 내용은 티타임즈 "삼성전자와 SK하이닉스가 AI 시대를 이끌어가는 방법" 유튜브 영상 및 서울대 투자동아리 SMIC SK하이닉스 기업분석을 바탕으로 기타 기사들을 참조하여 내용 정리 및 내용 추가를 하였다.

GPU 시장에서 강조되는 HBM

gpu 성능을 어필하기 위해 탑재된 트랜지스터의 수, 텐서코어, 뉴럴 엔진과 같은 인공지능 전용 코어가 몇 개나 들어가 있는지에 대하여 어필을 한다. 또한 5nm 4nm와 같은 반도체 최신 공정을 앞세우기도 한다.

그러나 최근들어 출시되는 반도체 스펙에서 HBM이 탑재되었다는 부분이 강조되어지고 있다.

- 엔비디아는 차세대 ai칩 gh 100을 공개하면서 hbm3e 모델을 탑재했다고 강조하였다.

- AMD는 자사의 최신 인공지능형 반도체 mi300x를 공개하면서 HBM을 탑재했다고 어필하였다.

- 엔비디아 h100대비 2.4배 더 많은 hbm을 탑재했다고 자랑

- 서버용 CPU 시장을 꽉 잡고 있는 intel 역시 hbm을 결합한 새 제품 인텔 제온 CPU 맥스 프로세서를 소개하였다.

Why HBM?

(1) 대 인공지능시대에서 반도체 성능 경쟁이 치열하다. AI 경쟁에서 늘 눈에 띄는 건 시스템 반도체 즉 gpu와 npu 같은 연산용 반도체이다.

하지만 메모리 없이는 연산도 없다. 연산용 반도체가 고도화되면 이에 맞춰 메모리 반도체의 성능향상도 뒷받침되어져야 한다. (메모리 반도체가 갑자기 AI 반도체에 탑재되기 시작하면서 주목받고 있는 것은 아니라 연산용 반도체와 늘 함께 중요시 여겨져왔다.)

(2) HBM은 메모리 반도체이다.

- 컴퓨터 시스템을 구성하는 핵심 요소 두 가지는 ‘연산’과 ‘저장’이다.

- 거의 모든 컴퓨터 시스템은 연산 장치에서 저장장치에 있는 데이터를 가져와서 연산하고 다시 저장하는 폰 노이만 구조이다.

- 저장 장치에서 연산을 하는 프로세스인 메모리 PIM(Process In Memory),PNM(Process Near Memoy) 개념도 등장하긴 했지만 아직 상용화와 단계는 아니다. 이는 연산만을 수행하는 반도체의 성능을 메모리 반도체가 따라잡기에는 아직 무리이기 때문

- 메모리 반도체 성능이 뒤쳐지게 된다면 시장에서 선두주자가 될 수 없으며 intel, amd, 엔비디아 등 시장의 주요 player들은 뒤쳐지지 않도록 hbm물량을 확보하기 위해 안간힘을 쓰고 있다.

(3) CPU/GPU 제품을 생산하기 위해 여러 반도체 회사들의 도움이 필요하다.

- 시스템 반도체 생산: TSMC

- 메모리 반도체 생산: SAMSUNG, SK Hynix

What is HBM

Part 1. 메모리 반도체란?

메모리 반도체 = 정보를 저장하고 저장된 정보를 다시 시스템 반도체가 연산할 수 있도록 읽어내고 전송하는데 특화한 반도체

(1) 메모리 반도체는 크게 RAM, ROM으로 나뉘어 진다.

- RAM(Random Access Memory): 휘발성 메모리

- 전력이 공급되는 동안만 데이터를 저장되며 전력이 차단되면 데이터는 날아간다.

- ROM(Read-Only Memory): 비 휘발성 메모리

여기서 RAM은 Random Access Memory의 약자이다.

여기서 Random이라는 것은 같은 연산 반도체가 메모리 반도체의 정보를 요구했을 때 정보를 가져오는 방식의 특성을 따온 것이다.

- 램 이전에 메모리는 필요한 정보가 있으면 처음부터 순서대로 접근해서 해당 위치에 도달하였다.

- 예를들어, 20페이지짜리 서류에서 15페이지를 보기 위해서는 1페이지에서 14페이지까지 하나하나 넘긴 다음에 볼 수 있었으며 데이터의 위치에 따라 불러오는 속도가 달라진다.

반면, RAM은 15페이지에 있는 정보를 불러오기 위해 바로 15페이지를 여는 방식이다.

- 데이터가 메모리 내부에 있기만 하면 몇 페이지에 있든간에 항상 같은 속도를 유지하면서 데이터를 불러올 수 있다.

- 순차적으로 접근하지 않고 임의대로, 아무렇게나 접근한다는 의미에서 Random이 붙게 되었다.

(2) RAM은 다시 SRAM과 DRAM으로 다시 나뉘어 진다.

- SRAM: Static RAM (Cache Memory)

- 제조비용은 비싸지만 동작속도가 DRAM대비 100배이상 빠르며 꼭 필요한 것에서만 탑재 (ex. 캐시 메모리)

- DRAM: Dynamic RAM

- 메모리 시장에서 가장 큰 규모를 차지

- 1966년 IBM에서 처음 개발 (로버트 H.데나드 박사)

- DRAM은 CPU의 성능향상, 새로운 전자기기의 등장과 함께 성장해옴

(3) DRAM의 표준 DDR(Dual Data Rate) RAM의 등장

(a) 시스템반도체와 메모리 반도체는 끊임없이 데이터를 교환하면서 컴퓨터로 작동한다.

(b) 데이터를 아무 때나 주고 받으면 비효율적이다. 그렇기에 시스템 반도체와 메모리 반도체는 연산 반도체 회로에 가해지는 전기적 진동을 클럭에 맞춰 데이터를 주고 받기로 약속하기로 하였다.

전통적 DRAM 한계점

첫째, 속도의 한계

- DRAM의 데이터 전송률이 시스템의 프로세서 속도에 비해 상대적으로 느렸음

- 초기의 DRAM은 데이터 버스를 통해 한 번에 한 비트의 데이터만 전송할 수 있는 SDR(Single Data Rate) 방식을 사용

둘째, 클록 신호의 비효율적 활용

- SDR DRAM은 클록 신호의 한 주기(period)에 데이터를 한 번만 전송한다.

- 이는 매 클록 신호마다 데이터 전송 효율이 절반으로 줄어드는 문제를 야기한다.

DDR은 SDR 전송방식을 개선한 데이터 전송 방식 기법이며 지난 20년간 DRAM의 표준은 DDR (Double Data Rate) 메모리가 차지해왔다.

- 기존 S(Single)DR 대비 우수한 성능과 간단한 물리적 구조 등의 장점을 지닌ㄴ다.

- 성능의 개선에 따라 따라 숫자를 붙여 DDR의 세대가 구분되어졌으며 현재 DDR5에 이르게 됨

기존에 GPU/CPU와 DRAM과 연산 반도체의 거리가 떨어져 있었다면, 정보 송수신 속도를 높이기 위해 ddrm은 점차 cpu나 gpu에 근처에 배치되기 시작되어졌다.

- gpu가 인공지능 연구의 대세가 되면서 gpu와 짝을 이루는 그래픽용 ddrm 즉 gddr 램도 등장하였다.

Part 2. 시장의 수요 및 HBM의 등장

인공지능 시대가 본격화하면서 저장하고 전송해야 할 데이터양이 기하급수적으로 늘어나면서 업계에서는 더 많은 요구사항들이 생겨나게 되었다.

- 대역폭(메모리에서 한번에 빼낼 수 있는 데이터 양) → 더 높게!

- 반응속도(CPU, GPU 요청에 대한 반응속도) → 더 빠르게!

- 용량(데이터를 얼마나 담을 수 있는지) → 더 크게!

여기서 HBM은 이러한 시장의 요구사항을 해결해줄 제품이다.

HBM은 High Bandwidth Memory의 줄임말이다. 직영하면 ‘고대역폭 메모리’ 이다.

- 메모리에서 한 번에 많은 양의 데이터를 빼내는 대역폭이 높은 메모리를 필요로 하는 시장 수요에 맞춰 개발된 제품이다.

- 도로로 비유하면 DRAM은 1차선, HBM은 12차선

- 차선이 많을 수록 한번에 통행할 수 있는 자동차 수 up → 대역폭이 높다! → 통행할 수 있는 데이터 양이 많다!

- 이는 유의미한 속도와 양의 차이를 일으킬 수 있다.

HBM vs GDDR

앞서 gpu가 인공지능 연구의 대세가 되면서 gpu와 짝을 이루는 그래픽용 ddrm 즉 gddr 램도 등장 한 내용을 언급하였다.

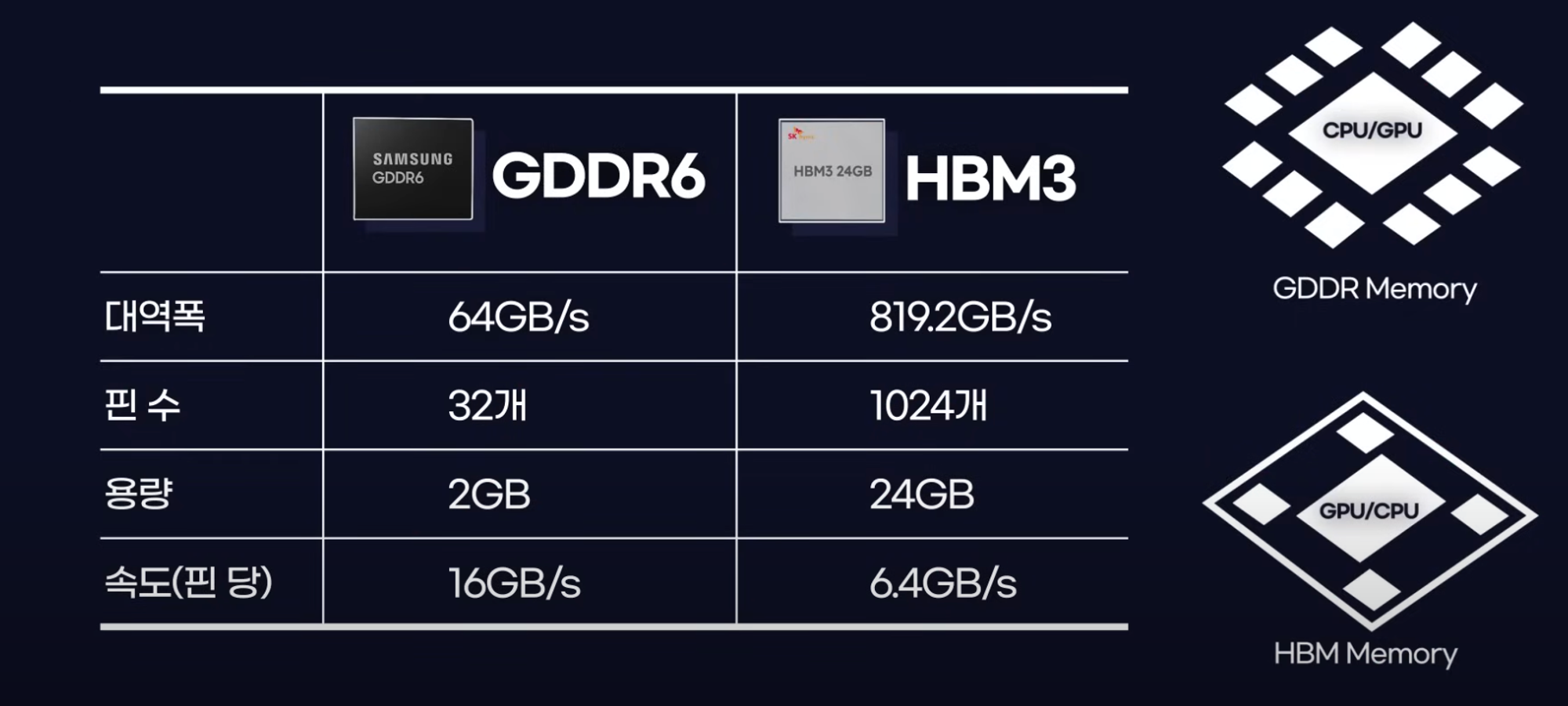

그렇다면 상용화에 성공한 최신모델인 삼성의 GDDR6와 SK하이닉스의 HBM3에 대하여 성능을 비교해 보자.

- 대역폭: HBM이 약 4.3배 높음

- GDDR = 64 * 12 = 768 GB/s (12개 배치 가정)

- HBM = 819.2 GB/s * 4 = 3276.8 GB (4개 배치 가정)

- Full HD 영상을 1초만에 625편을 전송하는 속도

- 핀의 수: 정보가 오가는 끝 구간

- GDDR = 32개 * 12 = 384개 (12개 배치 가정)

- HBM = 1024개 * 4 = 4096개 (4개 배치 가정)

- 고속도로로 비유하자면 GDDR은 톨게이트가 384개, HBM은 4096개

- 용량: HBM이 4배 높음

- GDDR = 2GB * 12 = 24GB (12개 배치 가정)

- HBM = 24GB * 4 = 96GB (4개 배치 가정)

- 24GB가 일반적인 use case에서 아쉬운 용량은 아니나 인공지능이 학습해야 하는 데이터 양을 고려했을때 아쉬운 양

- 속도(핀 당): GDDR이 유일하게 앞서는 특성

- GDDR = 16GB/s

- HBM = 6.4GB/s

- 칩을 설계하는 과정에서 발열 문제가 생길 수 있어 hbm을 구성하는 개별 칩에 동작 속도를 의도적으로 낮춰둔 상태

- 무리해서 속도를 높일 필요는 없으며 오히려 이정도 속도가 전력 효율면에서 더 좋다고 함

HBM을 만드는 방법?

- 각 제조사별로 HBM을 만드는 노하우가 다르다. (SK 하이닉스 경우 적층식으로 구현하였다.)

핵심 경쟁력은 메모리 반도체든 연산 반도체든 한정된 공간에 트랜지스터를 많이 집어넣는 집적 기술이다.

- 현실적으로 단기간에 시장에서 요구되어지는 만큼 집적도를 늘리기는 어렵다.

여기서 쌓아 올린 칩들이 서로 원할하게 작동할 수 있도록 하는 기술을 TSV (실리콘 관통 전극)이 이용되어 진다. 이러한 한계점을 극복하기 위해 쌓아 올리는 아이디어와 패키징 기법으로 해결한 것이다.

TSV: 층층히 쌓인 DRAM의 미세구멍을 뚫고 위아래 수직으로 관통하는 전극으로 연결하는 패키징 기술

HBM은 칩 하나로 기존 칩 12장에 달하는 용량을 확보할 수 있게 하는 기대효과를 가져다 준다.

- 전체 DRAM에서 차지하는 시장의 비중은 1.5% 수준(2023년을 기준으로 20억 4186만 달러)으로 미미함 그러나 28년 63억 2150만 달러로 시장의 성장을 전망함

HBM 시장 현황

- sk하이닉스가 삼성보다 앞서가는 이유는 사실 sk가 가장 먼저 hbm을 개발했기 때문입니다 2013년에 amd와 함께 d램을 내장 쌓아 올린 1세대 hbm을 개발

- HBM2e는 HBM 표준으로서는 처음으로 GDDR 표준의 성능을 능가

- sk의 hbm의 탑재는 엔비디아의 h100 시리즈

- MR-MUF 공정을 통해 타 공정 대비 생산성의 우위성을 가짐

- 삼성의 hba 탑재는 인텔과 미국 아르곤 국립연구소 축한 슈퍼컴퓨터 오로라 미국 로렌스 리버모어 국립연구소의 슈퍼컴퓨터 엘캐피탈 등에서 이용되었다.

- 삼성전자가 24년 2분기 ‘괴물 고대역폭메모리’로 꼽히는 HBM3E 12단H 제품 양산에 돌입한다고 밝힘. 이는 삼성전자가 엔비디아에 이 제품의 샘플을 제공하는 상황에서 엔비디아로의 납품을 사실상 공식화한 셈 (출처 기사)

이처럼 뛰어난 성능 덕분에 hbm은 엔비디아 AMD 인텔을 비롯한 반도체 공룡들이 자사의 플래그십 인공지능 반도체의 꼭 채택하는 제품이 되어지게 되었다.

해결해야 할 과제 = 비싼 가격

- GDDR과 같은 기존 DRAM 대비 2배에서 5배 비싸서 시장성이 높지는 않음

- 기술이 고도화되고 생산비용이 낮아지게 되면 더 많은 수익창출을 낼 수 있을 전망

- 최근에는 노트북에도 HBM을 탑재하게 되며 인공지능이나 슈퍼컴퓨팅의 한정된 용처가 확대되기 시작하면 시장의 확대 기대

'투자공부 > 반도체' 카테고리의 다른 글

| [투자공부] 퀄컴 기업분석 (0) | 2024.09.29 |

|---|---|

| [투자공부] ARM 기업분석 (1) | 2024.05.12 |

| [투자공부] BESI 기업분석 (feat. 하이브리드 본딩 공정) (0) | 2024.04.27 |

댓글